이미지 텍스트 확인

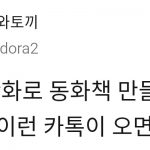

(1)나이트쉐이드에 의해 손상된 모델로 생성된 이미지(아래)와 원본 (사진=시카고대학)

(2)아티스트의 창작물을 동의 없이 인공지능(AI) 모델훈련에 활용하는 것을 방지하는 도구 ‘나이트쉐이드(NightShade)’가 대단한 반응을 일으키는 것으로 알려졌다.

(3)벤처비트는 29일(현지시간) 시카고 대학 연구진이아티스트 동의 없이 이미지를 학습에 사용할 경우해당 AI 모델을 손상하는 무료 도구 ‘나이트쉐이드’를 지난 18일 출시, 5일 만에 25만건의 다운로드를 기록했다고 보도했다.

(중략)

이미지 텍스트 확인

(1)나이트쉐이드는 이미지 픽셀에 눈에 보이지 않는

(2)수정 사항을 주입하는 방식으로 AI 훈련에 사용하는 데이터셋을 오염시켜 AI가 이미지를 잘못 해석하게 만든다. 예를 들어 AI가 고양이 사진을 개라고믿게 만들 수 있고, 그 반대의 경우도 가능하다. 사용자가 손상된 AI에 ‘고양이’ 이미지를 요청한 경우,나이트쉐이드로 인해 ‘고양이로 라벨이 지정된개’를 얻게 되는 식이다.

(1)즉 나이트쉐이드를 사용하면 아티스트가 일방적으

이미지 텍스트 확인

(2)로 피해만 보는 것이 아니라, 적극적인 반격이 가능해지게 됐다.

(3)시카고 대학은 나이트쉐이드 정식 출시 직후, 다운로드 시도가 폭주해 복사본을 다운로드할 수 있는미러 링크를 추가했을 정도라고 밝혔다.

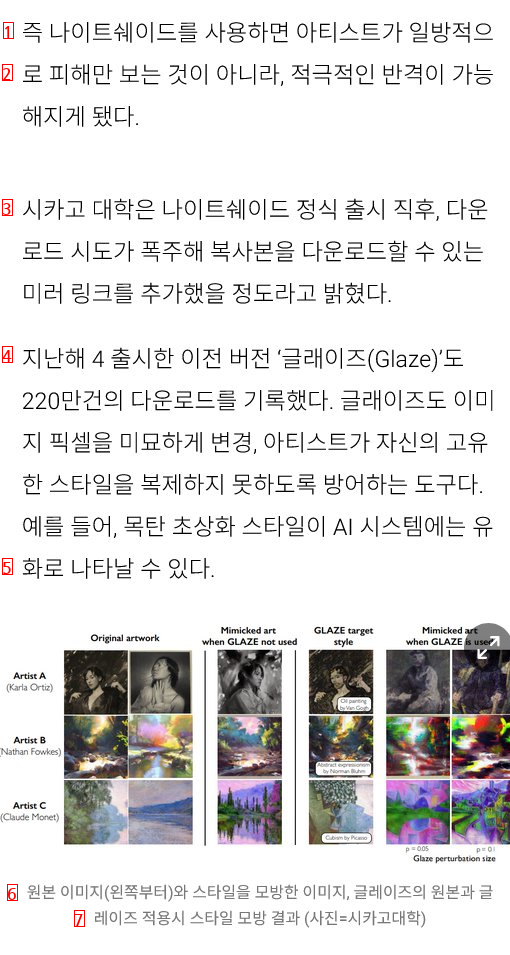

(4)지난해 4 출시한 이전 버전 ‘글래이즈(Glaze)’도220만건의 다운로드를 기록했다. 글래이즈도 이미지 픽셀을 미묘하게 변경, 아티스트가 자신의 고유한 스타일을 복제하지 못하도록 방어하는 도구다.예를 들어, 목탄 초상화 스타일이 AI 시스템에는 유

(5)화로 나타날 수 있다.

(6)원본 이미지(왼쪽부터)와 스타일을 모방한 이미지, 글레이즈의 원본과 글

(7)레이즈 적용시 스타일 모방 결과 (사진=시카고대학)

(하략)

출처 가서 관련기사 찾으면 다른 도구들도 나오는 모양입니다