이미지 텍스트 확인

U+ 6:26 ‘;

4 X 터q 씨ll (22

게시하기

영어 원문의 Google 번역

이건 미친 짓이야

삼성의 새로운 Al 모델; DeepSeek 및 Gemini

2.5 Pro보다 10,000배 더 작아 ARC-AGI 1 및

2예서 앞서나감

삼성의 초소형 재귀 모델(TRM)은 일반적인

LLM보다 약 10,000배 작지만, 단순히 텍스트트

예측하는 대신 재귀적으로 생각하기 때문에 더욱

스마트합니다. 먼저 답안 초안을 작성한 다음,

추론올 위한 숨겨진

‘스크래치패드”틀 구축하고,

반복적으로 논리틀 비판하고 개선하여(최대 16회),

매 주기마다 개선트 답을 도출합니다:

이 접근법은 아키택처와 추론 루프(단순히 크기만이

아니라)가 지능올 축진할 수 있음올 보여중니다:

강력하고 효율적인 모델올 구축하여 저럼하게

실행하고, 신경 기호 아이디어릇 검증하여, 훨씬 더

다양한 응용 분야에 최고 품질의 추론올 적용할 수

잇도록 지원합니다:

가속은 어디에나 있습니다

답글 게시하기

U+ 6:26 ‘;

이미지 텍스트 확인

0 X

지 ill (22

게시하기

Less is More: Kecursive

‘Keasoning with

Networks

Alexia Jolicoeur-Martineau

Samsung SAIL Montreal

alexiajosamsung-com

Abstract

CrCr; ortrapy lo s

8

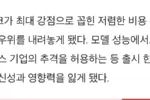

Hierarchical Reasoning Model (HRM) is

novel approach using twO small reural net-

Fninren

Embcddirg

Works recursing at different frequencies

This

8

biologically inspired method beats Large Lar-

guage models (LLMs) on hard Puzzle tsks

such as Sudoku Maze, and ARC-AGI while

Add & Norm

trained with small models (27M parameters)

MLP

srmall data (~ I(N examples) HRM holds

great prumise for solving hard problems with

Aid

Norm’

small nctworks

but it is not yet well

8

derstood and may be suboptimal

We Pro `

Sll wenvon

Pose

Rccursive Model

(IRM)

much

simpler recursive reasoning approach that

achieveg significantly higher generalization

than HRM, while using

sinsle

network

Inpu (비)

Prediclion (yI

Lalenl (z

CJe SuD7I

IAnswerl

IRaasoninal

with only

layers With only 7M Parameters;

TRM obtains 4596 test accuracy on ARC ACI

and 876 on ARC-AGI-2 higher than most

LLMs

Decpseek Ri o3-mini Gemini 25

withless than O01%6 of the parameters

Step

Urda’a

Given ^

mpyove (hd uloni리

‘

1. Introduction

S unncve

‘Unapiedgwony?

While

powerful Large Language models (LLMs) can

struggle on hard question-answer

problemsg

Given

Anrloi Nsus

16 timof

miptorfy tnu Erudicton y)

that they Benerate their answer auto-regressively there

hichrsk of error sinice

siriele incorrect token can

Jackson Atkins

JacksonAtkinsx

19시

My brain broke when

readthis paper

tiny 7 Million parameter model just beat

DeepSeek-R1, Gemini 2.5 pro, and 03-mini at

reasoning on both ARG-AGI1 and ARC-AGI 2

Less is More: Recursive

Reasoning with

Networks

Alexia Jolicoeur-Martineau

Samsung SAIL Montreal

alexia josamnsung comn

Abstract

‘Cross ontrcpy

8

Hierarchical Reasoning Model (HRM) is

novel approach using two small neural net-

FUvalgt

Emnboddirya

works recursiny at different frequencies. This

8

biologically inspired meth(yd beats Large Lan

guage models (LLMs) on hard puzzle tasks

such ds Sudoku Maze; and ARC AGI while

Aid & NoT

trained with small models (27M pararmeters)

NLP

on small data (~ I0O exarnples) HRM holds

5

great promise for solving hard problems with

Aud

Nor

small networks,

but it i5 not yet well un-

S6l-Atonton

derstood and may be suboptimal

We Pro

7

U4

Tiv Recursive Mudel (TRM)

much

답글 게시하기

Tiny

Iiny

tny

(eB

Pro)

Itiig

Tiny

핵심 발견: 초소형 Al, TRM의 경이로운 능력

이미지 텍스트 확인

이 연구의 핵심은 TRM(Tiny Recursive Model) 이라

논 새로운 접근법이다. TRM은 인간이 어려운 문제튼 풀

때처럼, 한 번에 정답올 내놓는 대신 스스로의 답을 계속해

서 검토하고 추론 과정올 개선하는 ‘재귀적(Recursive)’

방식올 사용하다.

압도적인 효율성: TRM은 단 700만(7M) 개의 파라미

이미지 텍스트 확인

터틀 가져다 이튿 수천억 개 파라미터름 가진 최신 거대

Al 모델의 0.어1%도 안 되는 크기다:

인간 수준의 추론 능력: 스도구 미로 찾기, 그리고 시의

순수 추론 능력올 축정하는 궁극의 테스트인 ARC-AGI

벤치마크와 같은 고난도 퍼; 문제에서; TRM은 대부분의

거대 언어 모델올 압도하는 성능올 보없다:

ARC-AGI-1 테스트에서 TRM은 **44.69**의 정확도

틀 기록하여; 세계 최고 수준의 모델인 Gemini 2.5 Pro

(37.096) 틀 뛰어넘없다. ARC-AGI-2에서논 7.89틀 달

성하여; 이 역시 Gemini 2.5 Pro (4.996)와 기존 모델

HRM (5.09)올 능가하는 수치다.

초거대모델 왜 안하냐고 욕먹던 삼성이

온 디바이스용 Ai 쪽을 파면서 새로운 학습 알고리즘을 만들어냄